时间:2025-09-29来源:本站

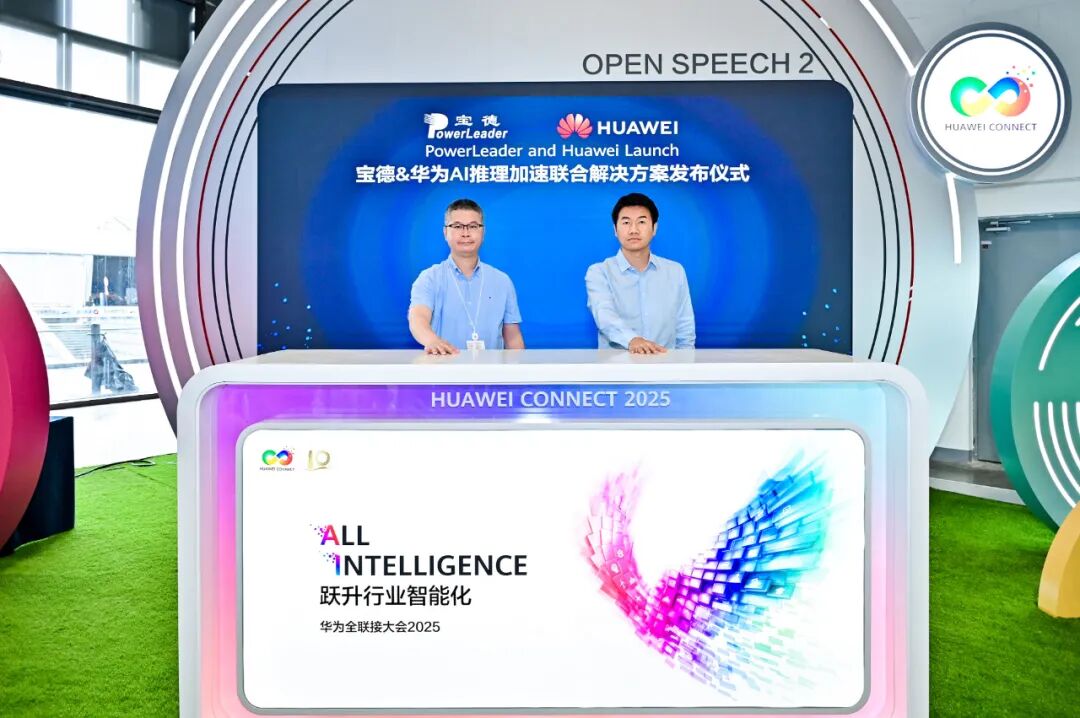

华为全联接大会2025期间,宝德计算与华为数据存储联合发布了AI推理加速解决方案。该方案基于宝德PLStack AI人工智能平台和华为OceanStor A系列存储的推理加速能力,助力企业应对大模型时代AI推理的关键挑战,加速AI大模型推理应用落地。

随着AI集群规模不断扩大,大模型训练集群故障率呈指数级上升,导致实际算力利用率不足50%,存在大量的算力资源浪费;同时,在推理场景下,随着序列长度及并发数量增加导致Token吞吐量降低,AI推理陷入算力重复消耗的恶性循环。这些问题严重影响了推理体验和效率,限制了AI技术在更多场景的广泛应用。

针对这些挑战,宝德计算与华为数据存储创新推出了AI推理加速联合解决方案,该方案基于宝德PLStack AI人工智能平台,采用华为UCM推理记忆数据管理器,实现KV Cache数据池化管理,基于大模型历史数据做推理加速优化。通过存储与计算的深度协同,为AI推理加速提供了全方位的技术支持。

●多元生态兼容:支持主流算力生态与存储深度协同,支持vLLM推理框架和CUDA生态,兼容多种大模型开发需求;

●极致推理加速:持久化KV Cache保存到华为A系列存储,实现推理记忆知识的全量保存,避免重复计算,使并发倍增,首Token时延最高降低90%,Token吞吐量提升两倍以上;

●训练效率提升:搭载华为A系列存储,支持DataTurbo客户端,提供极致文件读写性能,满足AI训练对高带宽诉求;

●极简运维管理:配套一站式全流程AI工具链统一纳管存储和计算资源,支持持久化工作目录、可视化文件管理、租户隔离等服务,降低运维复杂度。

在企业问答助手实测场景中,该推理加速方案采用以查代算提升推理吞吐,方案效果显著。数据显示,在简单问答场景中,首Token时延(TTFT)缩短1.5倍;多轮问答因涉及更复杂的上下文交互,加速效果尤为突出,推理吞吐提升两倍以上。同时,随着对话序列长度增加,推理体验提升变得更加明显。该方案为企业提供了更高效、更智能的问答服务。

宝德计算与华为数据存储的此次合作,提供了AI推理创新性的解决方案。目前该方案在金融、医疗等行业试点。未来,双方将持续深化合作,实现更多的推理加速方案能力,推动AI技术在更多行业的落地应用,助力行业智能化升级。